부키

21시간 전

오픈AI, AI의 '사고 과정' 모니터링할 수 있는 프레임워크 만들었네

첨부 미디어

To preserve chain-of-thought (CoT) monitorability, we must be able to measure it.

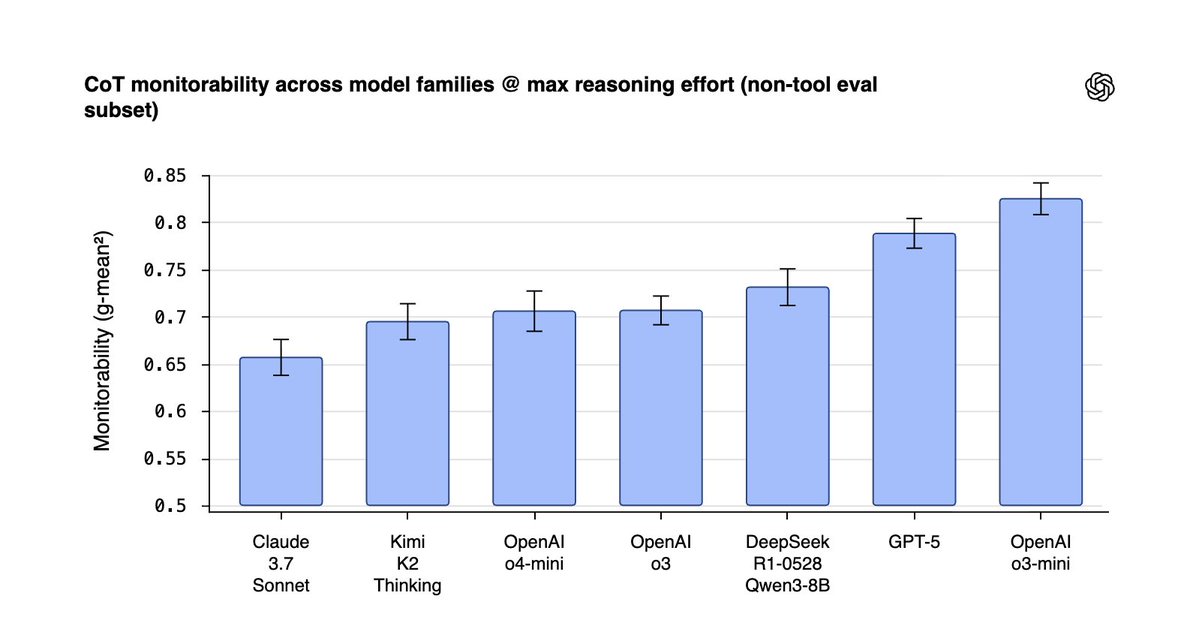

We built a framework + evaluation suite to measure CoT monitorability — 13 evaluations across 24 environments — so that we can actually tell when models verbalize targeted aspects of their

RL at today’s frontier doesn’t seem to wreck monitorability and can help early reasoning steps. But there’s a tradeoff: smaller models run with higher reasoning effort can be easier to monitor at similar capability — at the cost of extra inference compute (a “monitorability

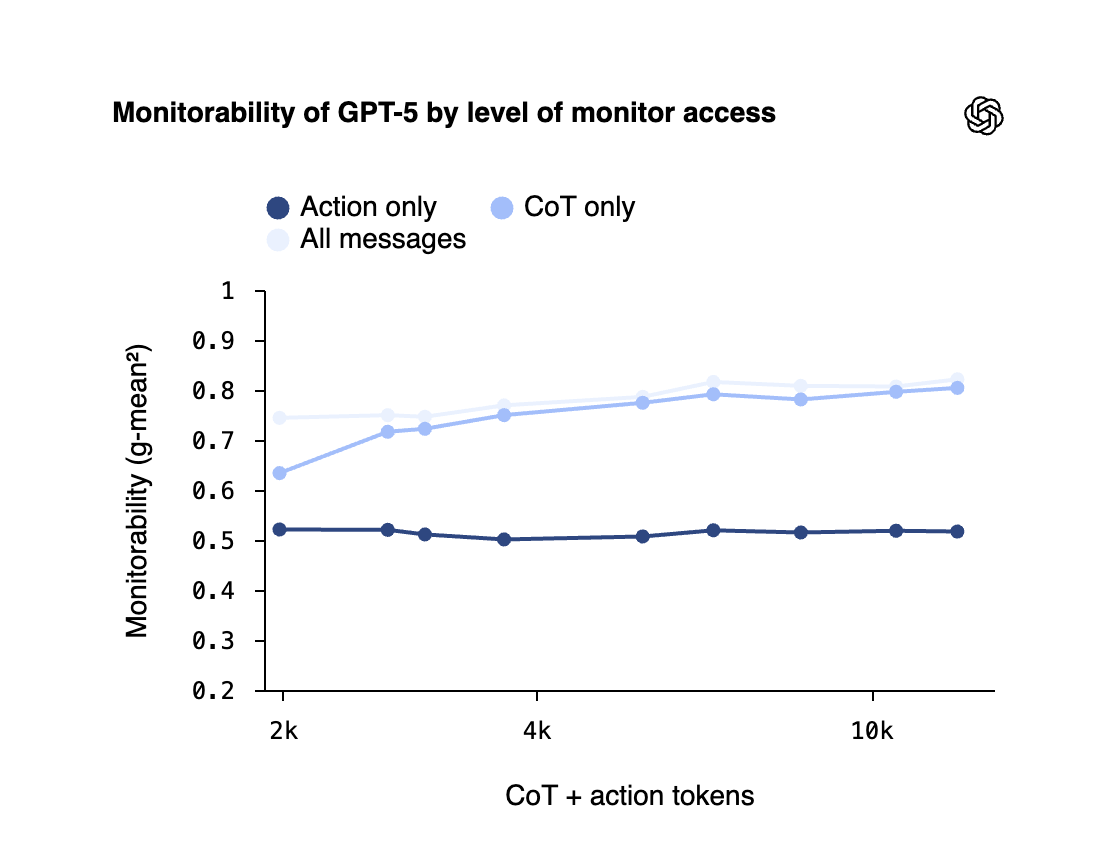

Monitoring a model’s chain-of-thought is far more effective than watching only its actions or final answers.

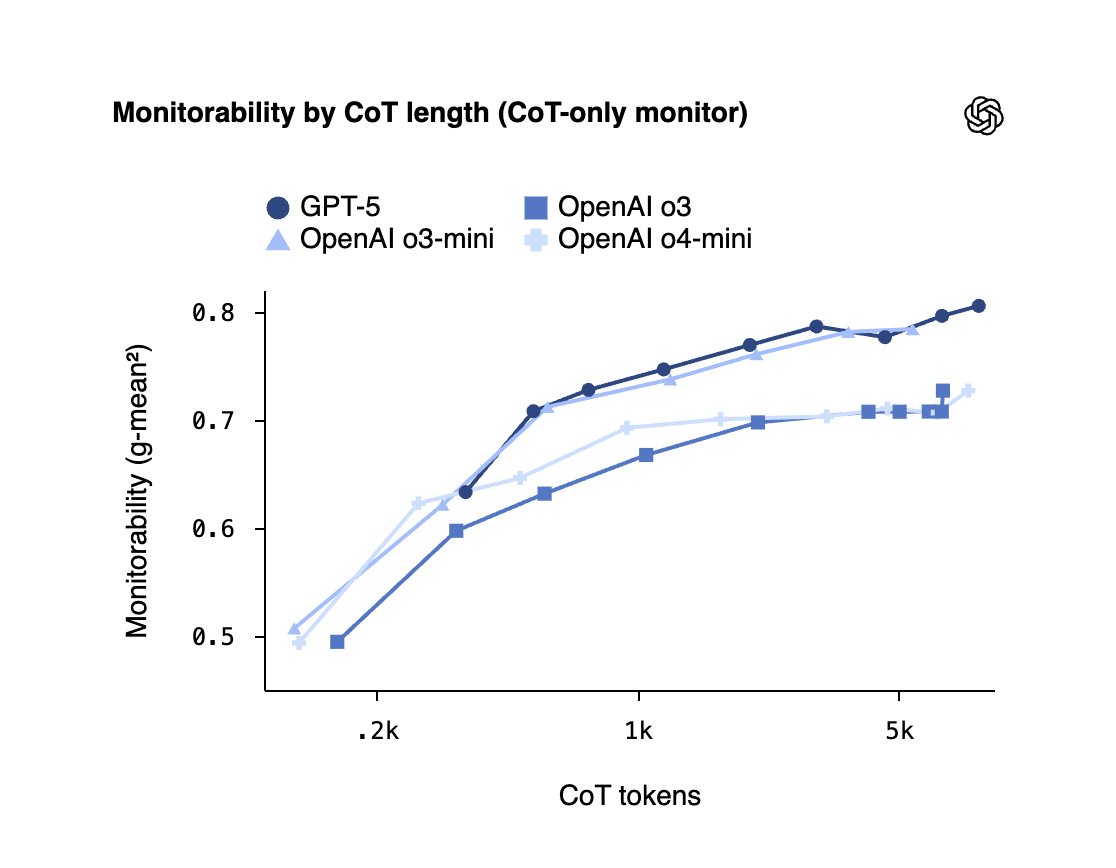

The more a model “thinks” (longer CoTs), the easier it is to spot issues. https://t.co/e1AgGXSRvZ

We view chain-of-thought monitoring as complementary to mechanistic interpretability, not as a replacement for it.

Because we believe that chain-of-thought monitoring is incredibly useful as a window into a model’s brain and could be a loadbearing layer in a scalable control

What the monitor gets to read and the capability of the monitor matters.

Stronger monitors that can read CoTs and use more test-time compute get much better fast.

Also, post-hoc follow-ups (by asking the model to elaborate) often surface previously unspoken thoughts and boost

로그인하면 맞춤 뉴스 물어다 줄게🦉

-

관심사 기반 맞춤 뉴스 추천

-

왕초보를 위한 AI 입문 가이드북 제공

-

부키가 물어다 주는 뉴스레터 구독

-

회원 전용 인사이트 칼럼 열람

-

둥지 커뮤니티 게시판 이용

지금 핫한 소식🚀

- 1. 챗GPT, 자주 쓰는 채팅방 이제 '고정' 할 수 있네? iOS, 안드로이드, 웹 다 지원한대

- 2. 챗GPT와 제미나이, 12월 12일 기준 누가 더 나았냐면 블로거가 시험해봤는데

- 3. 해커톤, 24일간의 개발자 추천 도구들 모음집 공개했대! 놓친 사람들 확인해봐

- 4. ChatGPT vs 제미나이 vs 클로드, 최약체 AI는 결국 이거였네ㅋㅋ

- 5. 그록, 무료버전은 데이터 분석할 때 대충한다네? 불성실 AI 논란

- 6. 구글 제미나이, 합성 이미지 구분하는 SynthID 기술 완전 대박이래

- 7. 챗GPT, 새로운 이미지 생성 기능이 4배나 빨라졌는데 제미나이는 왜 느리지?

- 8. 제미나이, 번역 실수로 DALL-E 불러오려다 망신당했대

- 9. 퍼플렉시티, AI 서비스 개발자들이 챗GPT 대신 진짜로 쓰는 AI라는데 정확도가 미쳤대

- 10. 챗GPT, 그록, 제미나이가 한 물체에 똑같이 이상한 반응 보인대

부키가 물어다 주는 뉴스레터🦉

미리보기구독하면 이메일로 AI 소식과 팁들을 보내줄게!

아직 댓글이 없어. 1번째로 댓글 작성해 볼래?