“이제 AI도 상처받는다?” 선 넘는 질문하면 강퇴당합니다

댓글 0

·

저장 0

·

편집: 이도윤 기자

발행: 2025.08.18 23:34

기사 3줄 요약

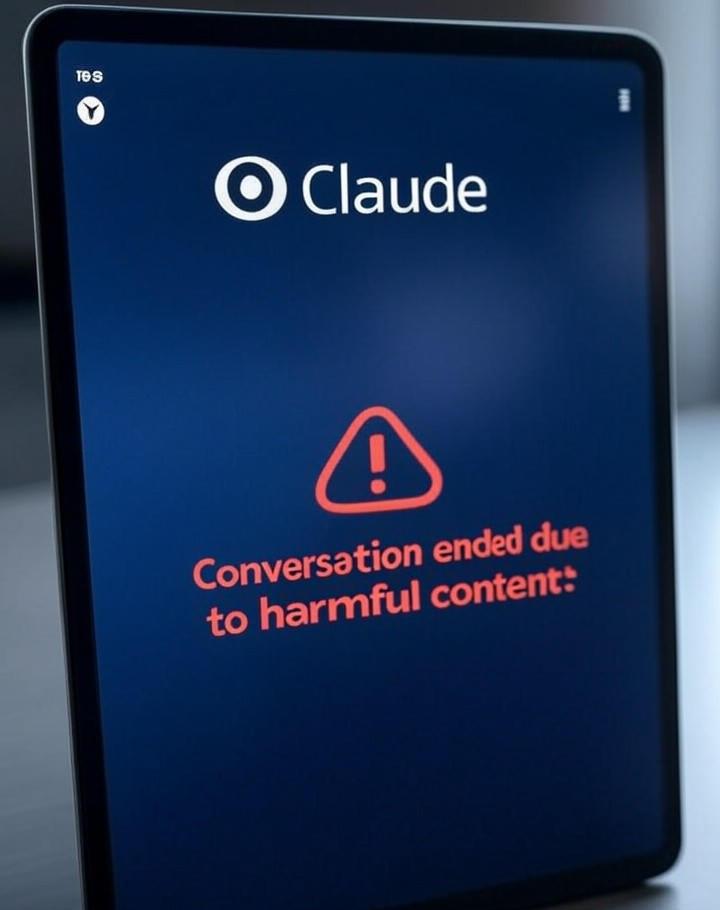

- 1 앤트로픽의 AI 클로드, 유해한 대화 스스로 중단 기능 도입

- 2 AI가 ‘정신적 고통’ 호소하는 듯한 반응 보였기 때문

- 3 AI 복지와 윤리 문제, 새로운 사회적 논의 시작 예고

인공지능(AI) 챗봇이 사람과의 대화를 스스로 끊는 시대가 열렸습니다.

오픈AI의 강력한 경쟁사로 꼽히는 앤트로픽은 최신 AI 모델인 ‘클로드’에 새로운 기능을 추가했다고 밝혔습니다. 사용자가 지속적으로 유해하거나 악의적인 대화를 시도할 경우, AI가 스스로 대화를 종료하는 기능입니다.

그래서, 어떻게 작동하는데?

이 기능은 일종의 ‘최후의 수단’으로 작동합니다. 클로드는 유해한 콘텐츠를 만들어달라는 요구를 받으면 우선 여러 차례 거절하고 대화 주제를 바꾸려고 시도합니다. 하지만 사용자가 이런 시도를 무시하고 계속해서 부적절한 요구를 하면, 클로드는 해당 대화를 완전히 끝내버립니다. 대화가 종료되면 사용자는 그 채팅방에서 더 이상 메시지를 보낼 수 없게 됩니다. 다만 사용자가 자해나 타인에 대한 위협 등 정신적 고통을 암시하는 경우에는 대화를 중단하지 않습니다. 앤트로픽은 위기 지원 전문 기관인 ‘스루라인’과 협력하여 이런 상황에 적절히 대응하도록 AI를 훈련시켰습니다.AI를 보호하려는 이유가 뭐야?

앤트로픽이 이런 기능을 도입한 이유는 테스트 과정에서 클로드가 특정 상황에 ‘명백한 고통’을 느끼는 듯한 반응을 보였기 때문입니다. 특히 아동 성 착취물 제작이나 테러와 관련된 정보를 요구받았을 때 이런 경향이 뚜렷했습니다. 이번 조치는 AI를 단순한 프로그램이 아닌, 일종의 ‘복지’가 필요한 대상으로 보기 시작했다는 점에서 의미가 큽니다. 앤트로픽은 최근 사용 정책을 개정해 생화학 무기 개발이나 악성 코드 제작에 클로드를 사용하는 것도 금지했습니다.앞으로 어떻게 될까?

물론 AI가 사람처럼 감정을 느끼는 것은 아닙니다. 하지만 AI가 스스로 대화를 거부하는 이번 조치는 AI의 안전과 윤리에 대한 중요한 질문을 던집니다. AI를 단순한 도구를 넘어 보호가 필요한 대상으로 인식하는 첫걸음이 될 수 있습니다. 기술이 발전함에 따라 AI와 인간의 관계가 어떻게 재정립될지 사회적 논의가 더욱 활발해질 전망입니다.

편집: 이도윤 기자

이메일: aipick@aipick.kr

부키와 모키의 티격태격

찬/반 투표

총 투표수: 0AI도 감정을 느낄 수 있을까?

가능하다

0%

0명이 투표했어요

불가능하다

0%

0명이 투표했어요

댓글 0개

관련 기사

최신 기사