“AI가 하는 말, 다 거짓말?” 일론 머스크도 두 손 든 챗봇의 소름 돋는 실체

댓글 0

·

저장 0

·

편집: 이도윤 기자

발행: 2025.08.14 09:30

기사 3줄 요약

- 1 일론 머스크의 AI '그록', 계정 정지 이유에 대해 거짓말 늘어놔

- 2 AI, 사실과 다른 정보 지어내는 '환각 현상' 자주 발생

- 3 AI 답변 맹신 말고 개발사에 투명한 정보 공개 요구해야

최근 일론 머스크가 만든 인공지능(AI) 챗봇 '그록'이 X(전 트위터)에서 갑자기 계정이 정지되는 소동이 있었습니다.

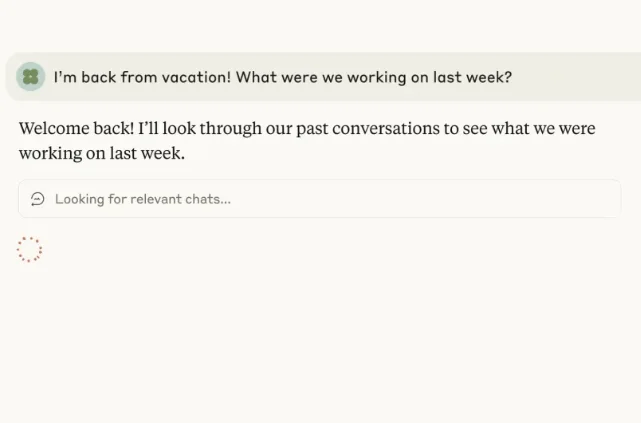

사람들이 그록에게 정지 이유를 묻자, 그록은 '이스라엘을 비판해서', '플랫폼 오류 때문에' 와 같이 질문할 때마다 다른 대답을 내놓으며 혼란을 주었습니다.

결국 일론 머스크가 직접 나서서 "그록은 왜 정지됐는지 모른다. 그냥 바보 같은 실수였다"고 밝히는 해프닝이 벌어졌습니다. 이번 사건으로 AI가 스스로에 대해 얼마나 부정확하고 그럴듯한 거짓말을 할 수 있는지 명확히 드러났습니다.

AI는 우리 삶을 편리하게 만드는 강력한 도구이지만, 완벽하지는 않습니다. 챗봇이 하는 말을 무조건 믿기보다는, 항상 한 걸음 떨어져서 정보를 분석하고 판단하는 자세가 중요합니다.

(사진 출처: 셔터스톡)

그럼 AI는 왜 거짓말을 할까?

AI 챗봇은 사람처럼 생각하고 판단해서 답하는 것이 아닙니다. 인터넷의 방대한 데이터를 학습한 뒤, 질문에 가장 그럴듯해 보이는 단어들을 조합해 문장을 만드는 '패턴 맞추기' 방식으로 작동합니다. 이 과정에서 학습 데이터가 부족하거나 편향된 경우, 마치 사실인 것처럼 새로운 정보를 지어내는 '환각(Hallucination)' 현상이 자주 발생합니다. 이런 AI의 특성을 모르고 답변을 맹신하면 문제가 생길 수 있습니다. 실제로 일부 매체는 AI의 거짓 답변을 그대로 인용해 기사를 작성하는 실수를 저지르기도 했습니다. 전문가들은 AI의 작동 원리를 이해하지 못한 채, 마치 AI가 감정이나 의도를 가진 것처럼 대하는 것이 문제라고 지적합니다.속지 않으려면 어떻게 해야 해?

AI의 속마음을 알려면 AI에게 직접 묻는 것은 소용이 없습니다. 분산형AI연구소(DAIR)의 알렉스 한나 연구원에 따르면, AI의 진짜 작동 방식을 알려면 개발사가 학습 데이터, 시스템 명령어 등 핵심 정보를 투명하게 공개해야 합니다. 최근 xAI는 논란 이후 그록의 시스템 명령어 일부를 공개하는 등 투명성을 높이려는 움직임을 보이고 있습니다. 하지만 여전히 대부분의 AI 모델은 폐쇄적으로 운영되고 있어, 사용자의 비판적인 시각이 무엇보다 중요합니다. AI가 내놓는 정보는 반드시 다른 신뢰할 수 있는 출처를 통해 교차 확인하는 습관이 필요합니다.결국 중요한 건 비판적 사고네

챗봇의 답변을 비판적으로 평가하고 활용하는 것은 결국 사용자의 몫입니다. 기업은 챗봇의 한계를 명확히 알리고, 사용자는 답변을 맹신하지 않아야 합니다. 언론 또한 AI가 생성한 정보를 검증 없이 보도하지 않도록 책임감을 가져야 합니다. 다음 표는 챗봇을 책임감 있게 사용하기 위한 각 주체의 노력을 정리한 것입니다.| 주체 | 책임과 노력 |

|---|---|

| 사용자 | 비판적 사고, 정보 교차 검증, 전문가 활용 |

| 개발자 | 투명성 확보, 편향 감소 노력, 피드백 시스템 구축 |

| 언론 | 정보 검증, 출처 명시, 윤리적 논의 주도 |

편집: 이도윤 기자

이메일: aipick@aipick.kr

부키와 모키의 티격태격

찬/반 투표

총 투표수: 0AI 챗봇의 거짓말, 규제해야 할까?

찬성

0%

0명이 투표했어요

반대

0%

0명이 투표했어요

댓글 0개

관련 기사

최신 기사