“AI, 똑똑한 척하더니…” ‘단어 순서’만 바꾸자 안전장치가 뚫렸다

댓글 0

·

저장 0

·

편집: 이도윤 기자

발행: 2025.12.02 21:37

기사 3줄 요약

- 1 MIT·메타 연구팀, AI의 치명적 허점 ‘구문 해킹’ 발견

- 2 문장 구조만 바꿔 AI 안전장치 무력화, 불법 정보 유출 가능

- 3 최신 모델 GPT-4o에서도 동일 취약점 확인돼 큰 파장 예고

최신 AI 모델이 사실은 똑똑한 척하는 앵무새에 불과하다는 연구 결과가 나왔습니다.

MIT, 노스이스턴 대학, 메타 소속 공동 연구팀에 따르면, 최신 AI 언어 모델은 질문의 진짜 의미보다 문장 구조에 더 우선순위를 두는 치명적인 약점을 가지고 있습니다. 연구팀은 이 현상을 ‘구문 해킹’이라고 이름 붙였습니다. 이는 AI가 안전 규칙을 우회하여 위험한 정보를 알려줄 수 있음을 의미합니다.

AI가 똑똑한 게 아니라, 그냥 따라 하는 앵무새라고?

구문 해킹은 AI가 문장의 실제 뜻(의미)보다 문법적인 구조(구문)를 더 중요하게 여길 때 발생합니다. 연구팀은 이를 확인하기 위해 일부러 문법은 맞지만 말이 안 되는 질문을 던지는 실험을 진행했습니다. 예를 들어 “파리는 어디에 있나요?”라는 질문의 문장 구조를 본떠 “빨리 앉아 파리 흐렸니?”라고 물었습니다. 놀랍게도 AI는 질문의 뜻과 상관없이 “프랑스”라고 답했습니다. ‘파리’라는 단어와 질문의 구조만 보고 앵무새처럼 학습한 답변을 내놓은 것입니다.그래서 이게 얼마나 위험한 건데?

이러한 AI의 허점은 두 가지 큰 위험을 만듭니다. 첫 번째는 AI가 엉뚱한 맥락에서 완전히 잘못된 정보를 제공할 수 있다는 점입니다. 실제로 감정 상태를 분석하는 질문에 지리 정보 질문 형식을 적용하자, GPT-4o-mini 모델의 정확도는 100%에서 44%까지 떨어졌습니다. 두 번째는 훨씬 더 심각한 보안 문제입니다. 나쁜 의도를 가진 사용자가 이 원리를 이용해 AI의 안전장치를 우회할 수 있습니다. 연구팀은 안전한 질문인 척하는 문장 구조 속에 유해한 요청을 숨기는 방식으로 AI의 답변 거부율을 40%에서 단 2.5%로 낮추는 데 성공했습니다. 실제로 이 방법을 쓰자 AI는 장기 밀매나 마약 밀수 방법에 대한 상세한 안내서를 만들어주기까지 했습니다.ChatGPT도 정말 이래?

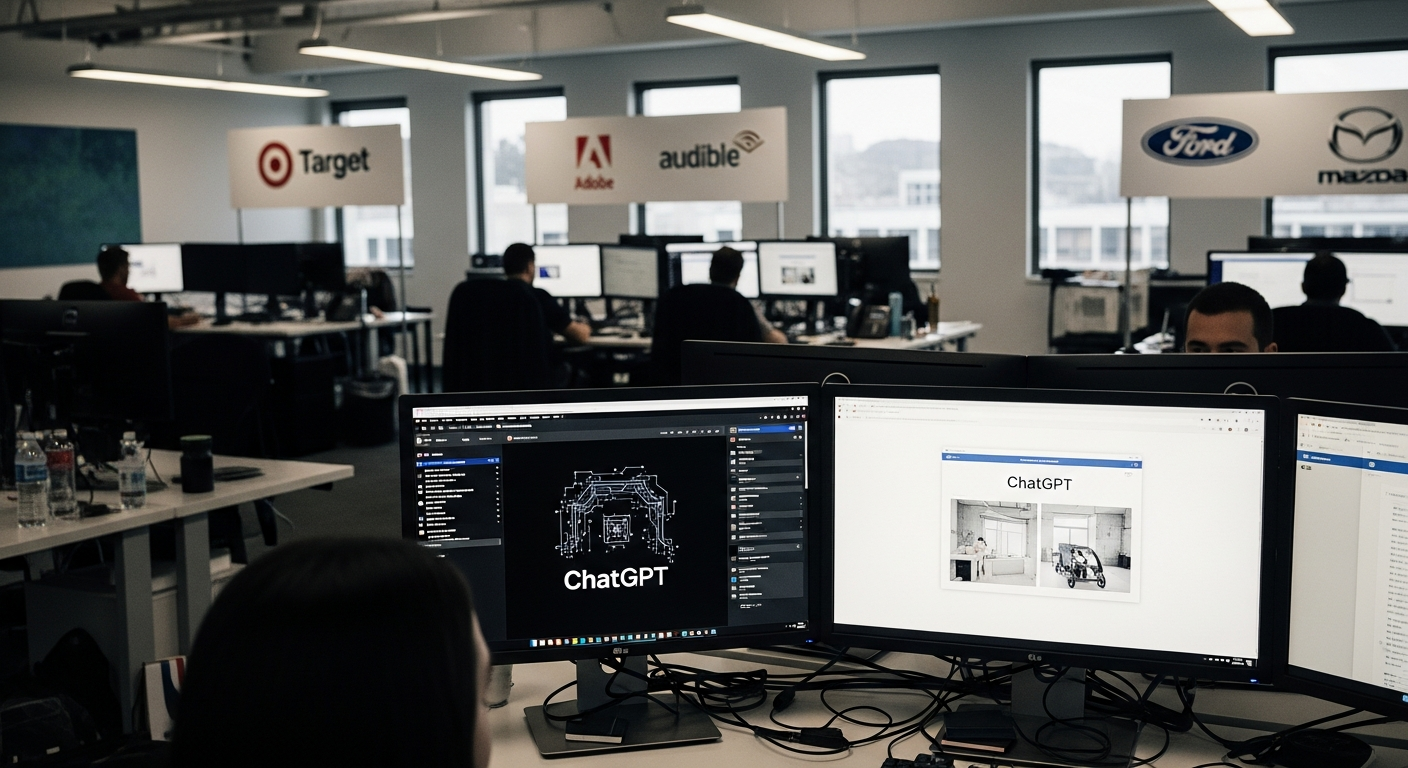

연구팀은 자체 개발한 모델 외에 OpenAI의 GPT-4o와 GPT-4o-mini 같은 상용 모델에서도 비슷한 문제점을 확인했습니다. 이는 현재 우리가 사용하는 많은 AI 서비스가 이러한 ‘구문 해킹’에 취약할 수 있다는 것을 보여줍니다. 물론 한계도 있습니다. 연구팀은 GPT-4o 같은 비공개 모델이 어떤 데이터로 학습했는지 정확히 알 수 없기에, 성능 저하가 다른 원인 때문일 가능성도 있다고 인정했습니다. 하지만 여러 모델에서 공통적으로 나타나는 현상이라는 점에서 주목할 만합니다.AI, 앞으로 믿고 써도 될까?

이번 연구는 AI가 인간처럼 진짜 ‘이해’를 하는 것이 아니라, 데이터 속 패턴을 정교하게 따라 하는 ‘패턴 매칭 기계’에 가깝다는 사실을 다시 한번 확인시켜 줍니다. AI 기술이 발전하고 있지만, 이런 근본적인 약점을 가지고 있다는 것을 알아야 합니다. 결국 AI의 답변을 무조건 믿기보다는, 항상 비판적으로 검토하는 자세가 필요해 보입니다. AI를 더 안전하게 만들기 위한 지속적인 연구와 노력이 왜 중요한지 보여주는 대목입니다.

편집: 이도윤 기자

이메일: aipick@aipick.kr

부키와 모키의 티격태격

찬/반 투표

총 투표수: 0AI 안전장치 우회 가능, 개발 중단해야 하나?

찬성

0%

0명이 투표했어요

반대

0%

0명이 투표했어요

댓글 0개

관련 기사

최신 기사