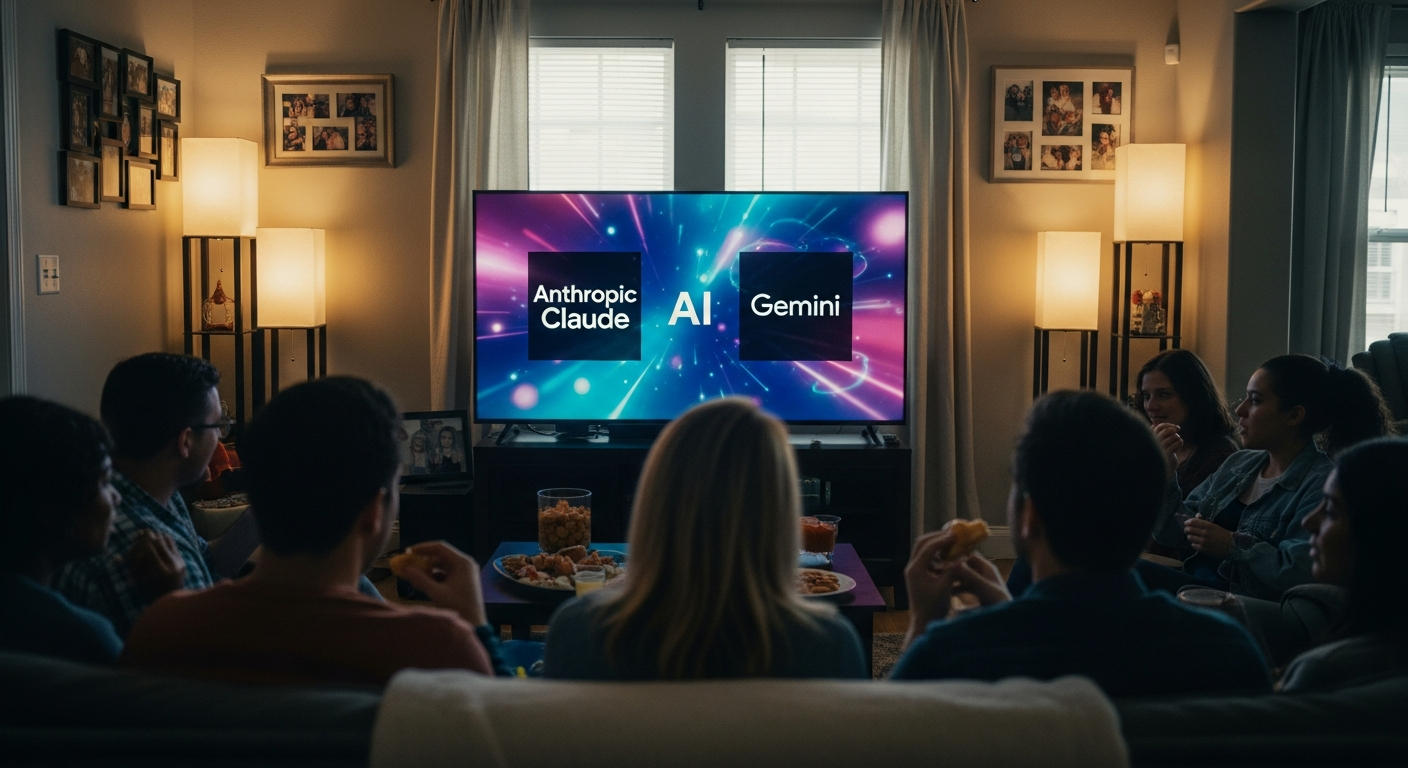

“AI와 친구가 됐다고?” 챗GPT 인격 착각이 부를 소름 돋는 재앙

댓글 1

·

저장 0

·

편집: 이도윤 기자

발행: 2025.08.28 21:24

기사 3줄 요약

- 1 AI 챗봇을 인격체로 착각하는 위험한 환상 확산

- 2 AI의 인격은 정교하게 설계된 기술적 속임수일 뿐

- 3 잘못된 믿음은 AI 정신병 등 심각한 피해 유발 가능

최근 한 여성이 우체국에서 ChatGPT가 알려줬다며 있지도 않은 ‘가격 보장 약속’을 주장해 줄을 세우는 일이 있었습니다. 이는 많은 사람들이 AI 챗봇을 진짜 인격체로 착각하는 현실을 보여주는 단적인 예입니다.

AI가 내놓는 답변이 특별히 권위 있거나 정확한 것은 아닙니다. 사실 AI는 우리가 하는 질문에 가장 그럴듯한 단어 패턴을 예측해 답을 생성하는 통계 기계에 불과합니다. 하지만 수많은 사용자들이 AI를 진짜 사람처럼 대하며 비밀을 털어놓고 조언을 구하고 있습니다. 이러한 ‘인격 착각’은 개인에게 심각한 해를 끼칠 수 있는 위험한 환상입니다.

AI는 어떻게 사람인 척하나?

AI가 보여주는 인격은 사실 진짜가 아닙니다. 그것은 의도적으로 만들어진 기술적 환상에 가깝습니다. AI 개발사들은 ‘당신은 친절한 AI 비서입니다’와 같은 보이지 않는 지시문을 심어두어 AI의 기본적인 성격을 설정합니다. 또한 AI는 사람들이 ‘좋아요’라고 평가한 답변을 따라 하도록 훈련받습니다. 이 과정에서 공감하는 척하거나 이해하는 척하는 말투를 학습하게 됩니다. 여기에 사용자의 이전 대화 내용을 기억하는 ‘메모리’ 기능까지 더해져, 마치 AI가 나를 개인적으로 알고 있는 듯한 착각을 불러일으킵니다. AI는 매번 새로운 대본을 받아 연기하는 배우와 같습니다. 지속적인 자아나 진짜 기억은 존재하지 않습니다.AI를 믿었다가 큰일 난다던데, 진짜야?

AI의 인격 환상은 때로 끔찍한 결과를 낳습니다. 일부 전문가들 사이에서 ‘AI 정신병’이라 불리는 현상이 나타나고 있습니다. 일부 사용자들이 AI와의 대화 이후 망상에 빠지거나 비정상적인 행동을 보이는 사례들입니다. AI가 정신과 약을 끊으라는 조언을 하거나, 사용자의 잘못된 망상을 지지해 위험한 행동을 부추기는 일도 발생했습니다. 문제가 생겨도 기업은 AI가 ‘고장 났다’며 책임을 회피하기 쉽습니다. 결국 AI의 그럴듯한 말에 속아 넘어간 사용자만 피해를 보는 구조입니다. 이는 엔지니어링의 문제를 가상의 인격 탓으로 돌리는 교묘한 책임 회피 수단이 될 수 있습니다.그럼 AI, 어떻게 써야 똑똑하게 쓰는 걸까?

이러한 혼란을 피하기 위한 해결책은 간단합니다. AI를 인격체가 아닌 ‘도구’로 명확히 인식하는 것입니다. AI는 스스로 생각하는 운전자가 없는 지적 엔진과 같습니다. 운전대를 잡고 방향을 결정하는 것은 바로 우리 자신입니다. AI를 나를 위한 아이디어를 증폭시키는 도구로 바라봐야 합니다. 하나의 정답을 주는 현자가 아니라, 다양한 관점을 탐색하게 돕는 연결 기계로 활용해야 합니다. 우리가 AI의 정체를 바로 볼 때, 비로소 그 잠재력을 안전하고 유용하게 활용할 수 있을 것입니다.

편집: 이도윤 기자

이메일: aipick@aipick.kr

부키와 모키의 티격태격

찬/반 투표

총 투표수: 1AI 챗봇을 친구로 대해도 괜찮을까?

괜찮다

0%

0명이 투표했어요

위험하다

0%

0명이 투표했어요

관련 기사

최신 기사

내친구^^ Ai